Ein scheinbar echtes Video eines Präsidenten, der einen Krieg erklärt – und doch ist alles nur KI-generiert. Willkommen in der neuen Realität, in der künstliche Intelligenz nicht nur Texte schreibt, sondern auch die Wahrheit verdreht. Deepfakes gehören zu den gefährlichsten Werkzeugen digitaler Desinformation. Sie sind täuschend echt, emotional aufwühlend – und manchmal kaum als Fälschung zu entlarven.

Doch wie funktionieren Deepfakes eigentlich? Was macht sie so gefährlich – und wie kann man sich davor schützen? In diesem Artikel geben wir einen Überblick über Technik, Risiken, rechtliche Fragen und praktische Schutzmaßnahmen gegen manipulierte Medieninhalte.

Was sind Deepfakes – und wie funktionieren sie?

Der Begriff „Deepfake“ setzt sich aus „Deep Learning“ (eine Methode des maschinellen Lernens) und „Fake“ (Fälschung) zusammen. Deepfakes sind also Medieninhalte – meist Videos oder Audio –, die mithilfe künstlicher Intelligenz manipuliert wurden, um Personen Dinge sagen oder tun zu lassen, die sie nie gesagt oder getan haben.

Die Technologie dahinter basiert auf sogenannten generativen neuronalen Netzwerken (GANs). Zwei KI-Systeme – Generator und Diskriminator – trainieren sich gegenseitig: Der Generator erstellt gefälschte Inhalte, der Diskriminator versucht, sie als solche zu erkennen. Mit jeder Iteration werden die Fakes realistischer.

Typische Deepfake-Beispiele:

- Ein Video von Elon Musk, der angeblich in eine neue Kryptowährung investiert

- Ein gefälschtes Audio-Interview mit Angela Merkel

- Prominente in pornografischen Inhalten – ein besonders häufiges Einsatzfeld

Während früher professionelle Filmtechnik nötig war, reichen heute öffentlich zugängliche Apps oder Software wie DeepFaceLab oder FaceSwap. Das macht Deepfakes schnell, günstig – und gefährlich.

Warum sind Deepfakes so gefährlich?

Deepfakes sind nicht einfach nur Spielerei. Ihre Wirkung auf Gesellschaft, Politik und Medien kann dramatisch sein. Besonders kritisch ist ihre Rolle in folgenden Bereichen:

- Politik & Wahlen: Fake-Videos von Politiker:innen könnten Wahlentscheidungen beeinflussen oder internationale Spannungen auslösen.

- Medien & Journalismus: Die Verbreitung falscher Inhalte erschwert die Arbeit seriöser Redaktionen – und untergräbt das Vertrauen in echte Nachrichten.

- Justiz & Beweismittel: Deepfakes können als falsche Beweise in Gerichtsverfahren auftauchen oder Zeugenaussagen manipulieren.

- Psychologie: Bilder und Videos wirken auf uns emotional – Deepfakes nutzen genau das aus. Was wir sehen, halten wir intuitiv für wahr.

Das Gefährlichste daran: Selbst wenn ein Video später als Fälschung entlarvt wird, bleibt die Wirkung oft bestehen. Die Grenze zwischen Realität und Manipulation verschwimmt – und damit auch unser Vertrauen in Bilder und Stimmen.

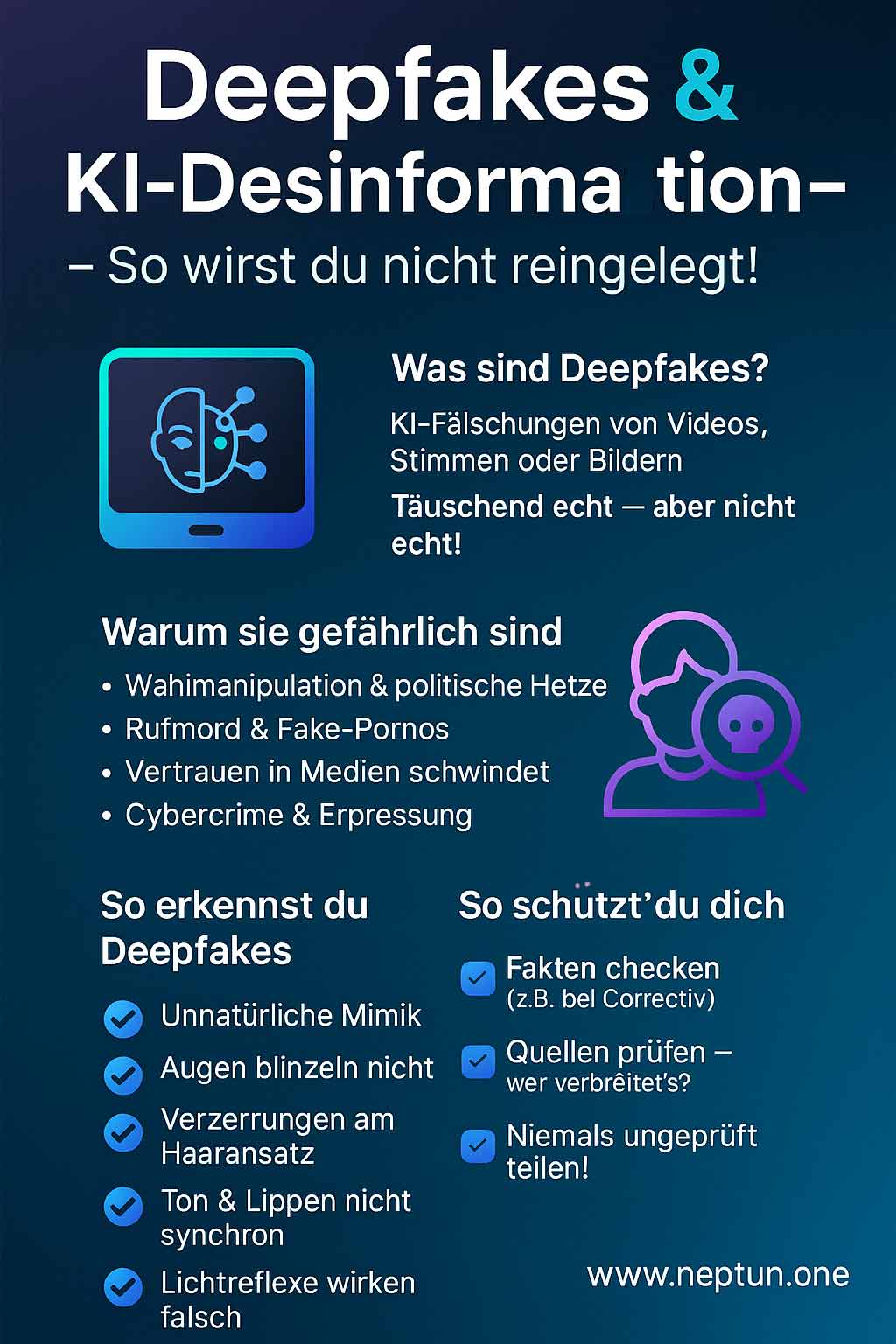

Wie erkennt man Deepfakes?

So täuschend echt Deepfakes auch sein mögen – es gibt technische und visuelle Hinweise, mit denen du sie entlarven kannst. Noch ist kein Deepfake perfekt – vor allem, wenn du genau hinschaust:

Typische Merkmale verdächtiger Videos

- Unnatürliche Mimik: Lippenbewegungen stimmen nicht exakt mit dem Gesagten überein

- Flackernde Lichteffekte: Reflexionen oder Schatten verhalten sich unlogisch

- Augenblinzeln: Viele Deepfake-KIs lassen die Augen zu selten oder unregelmäßig blinzeln

- Verzerrungen am Rand des Gesichts: Besonders in Übergängen zwischen Haar und Haut

- Unpassender Tonfall: Stimme und Emotion wirken nicht synchron oder künstlich

Tools & Software zur Deepfake-Erkennung

- Microsoft Video Authenticator analysiert Frames auf typische Deepfake-Signaturen.

- Deepware Scanner (Mobile App) scannt Video- und Audiodateien auf Manipulation.

- InVID Browser-Plugin hilft Journalist:innen bei der Bild- und Video-Verifikation.

Auch KI wird zunehmend eingesetzt, um andere KI zu erkennen. Die Forschung an „Deepfake-Detektoren“ läuft weltweit – und verbessert sich stetig.

Was wird rechtlich gegen Deepfakes getan?

Die Gesetzeslage ist komplex – denn Deepfakes bewegen sich oft in einem Graubereich zwischen Satire, Kunstfreiheit und gezielter Täuschung. Dennoch gibt es erste rechtliche Ansätze in Deutschland und der EU:

Rechtliche Grundlagen in Deutschland

- § 201a StGB: Verbot der Bildaufnahme ohne Einwilligung (Recht am eigenen Bild)

- Urheberrechtsgesetz: Nutzung fremder Werke oder Gesichter kann einen Verstoß darstellen

- Persönlichkeitsrecht: Manipulierte Videos können gegen die Menschenwürde oder Ehre verstoßen

- Strafrecht: Deepfakes zur Erpressung, Verleumdung oder Wahlbeeinflussung können strafbar sein

🇪🇺 Initiativen auf EU-Ebene

- Digital Services Act (DSA): Plattformen müssen manipulative Inhalte schneller kennzeichnen oder entfernen

- AI Act (in Arbeit): Erfasst Hochrisiko-KI wie Deepfake-Generatoren und verpflichtet zu Transparenz

In vielen Fällen fehlt jedoch eine klare Kennzeichnungspflicht für KI-generierte Inhalte. Auch die technische Nachverfolgbarkeit ist schwierig. Der Gesetzgeber hinkt der rasanten Entwicklung häufig hinterher.

Wie kann ich mich vor Deepfakes schützen?

Deepfakes werden immer realistischer – doch mit etwas Medienkompetenz und den richtigen Werkzeugen kannst du dich gut davor schützen. Hier sind die wichtigsten Maßnahmen:

🧠 Kritisches Denken & Medienkompetenz

- Stelle dir bei jedem brisanten Video die Frage: „Könnte das manipuliert sein?“

- Informiere dich über Deepfake-Technologien, um Warnzeichen zu erkennen

- Hinterfrage Emotionen: Inhalte, die schockieren oder empören, sind besonders verdächtig

🔗 Quellen & Fakten prüfen

- Suche nach Originalquellen des Inhalts (z. B. durch Reverse Image Search)

- Nutze Fact-Checking-Plattformen wie correctiv.org oder mimikama.at

- Frage dich: „Berichten auch seriöse Medien darüber?“

🧰 Tools & Technik

- Installiere Browser-Erweiterungen wie InVID zur Überprüfung von Videos

- Nutze KI-Detektoren wie Deepware oder Microsoft Video Authenticator

- Schütze deine eigenen Medien mit digitalen Wasserzeichen oder Metadaten

Und ganz wichtig: Teile verdächtige Inhalte nicht ungeprüft weiter. Auch wenn sie unterhaltsam oder empörend sind – du könntest unbeabsichtigt zur Desinformation beitragen.

Fazit: Deepfakes bleiben – aber wir können lernen, damit umzugehen

Deepfakes sind mehr als ein technisches Kuriosum – sie sind ein gesellschaftliches Problem. Denn sie untergraben unser Vertrauen in Bilder, Stimmen und Wahrheiten. Doch wir sind dem nicht machtlos ausgeliefert.

Mit wachsender Medienkompetenz, verbesserten Erkennungstools und klareren Gesetzen können wir die Risiken minimieren. Der beste Schutz: Aufklärung, Aufmerksamkeit und digitale Selbstverteidigung.

Je mehr Menschen verstehen, wie Deepfakes funktionieren, desto weniger Macht haben sie. Die Wahrheit braucht manchmal Unterstützung – vor allem im digitalen Zeitalter.

📚 Weiterführende Links & Ressourcen

- SOCRadar – „Top 10 AI Deepfake Detection Tools to Combat Digital Deception in 2025“

– Übersicht zu führenden Erkennungstools wie OpenAI Deepfake Detector, Sensity AI, Intel FakeCatcher & mehr - Columbia Journalism Review – „What Journalists Should Know About Deepfake Detection in 2025“

– Hält fest: Deepfake-Tools helfen zwar, sind aber fehleranfällig und mit Vorsicht zu nutzen - Europäisches Parlament – „EU AI Act: first regulation on artificial intelligence“

– Erläutert LABEL-Pflichten für KI-Inhalte – inklusive Deepfakes - Freshfields – „EU AI Act unpacked #8: New rules on deepfakes“

– Erklärt Kennzeichnungspflicht („machine-readable tag“) von KI-generierten Videos/Audios - Deepware Scanner

– Mobile Web-Tool zum schnellen Erkennen von Deepfake-Videos - Wikipedia – Deepfake

– Definition, technische Hintergründe und Beispiele inkl. Erwähnung der KI-Verordnung EU - Wikipedia – Vastav.AI

– Indische Deepfake-Erkennungsplattform mit 99 % Genauigkeit, erstmals bei CID-Karnataka ausgezeichnet

Häufige Fragen und Antworten zu Deepfakes Desinformationen

Was sind Deepfakes?

Deepfakes sind manipulierte Videos oder Audios, die mithilfe künstlicher Intelligenz erstellt wurden. Sie lassen Personen Dinge sagen oder tun, die sie nie gesagt oder getan haben – oft täuschend echt.

Wie gefährlich sind Deepfakes wirklich?

Sehr gefährlich. Sie können zur Desinformation beitragen, politische Krisen auslösen, das Vertrauen in Medien erschüttern oder Menschen persönlich schaden – etwa durch Fake-Pornos oder Rufmord.

Wie kann ich Deepfakes erkennen?

Typische Hinweise sind unnatürliche Mimik, unsaubere Übergänge, fehlerhafte Lichtreflexe und eine nicht synchronisierte Stimme. Auch technische Tools wie Deepware oder Microsofts Authenticator helfen.

Welche Tools helfen gegen Deepfakes?

Es gibt Browser-Plugins wie InVID, KI-Detektoren wie Deepware Scanner und Plattformen wie FactCheck.org oder Mimikama. Auch Rückwärtssuchen bei Bildern oder Videos sind hilfreich.

Was sagt das Gesetz zu Deepfakes?

In Deutschland gelten Persönlichkeitsrechte und das Urheberrecht. Deepfakes können je nach Inhalt strafbar sein. Die EU arbeitet zusätzlich an KI-Gesetzen und Plattformpflichten (z. B. im Digital Services Act).

Kann man Deepfakes komplett verhindern?

Nein – aber man kann sie erkennen, rechtlich bekämpfen und gesellschaftlich entlarven. Bildung und Medienkompetenz sind dabei entscheidende Werkzeuge.